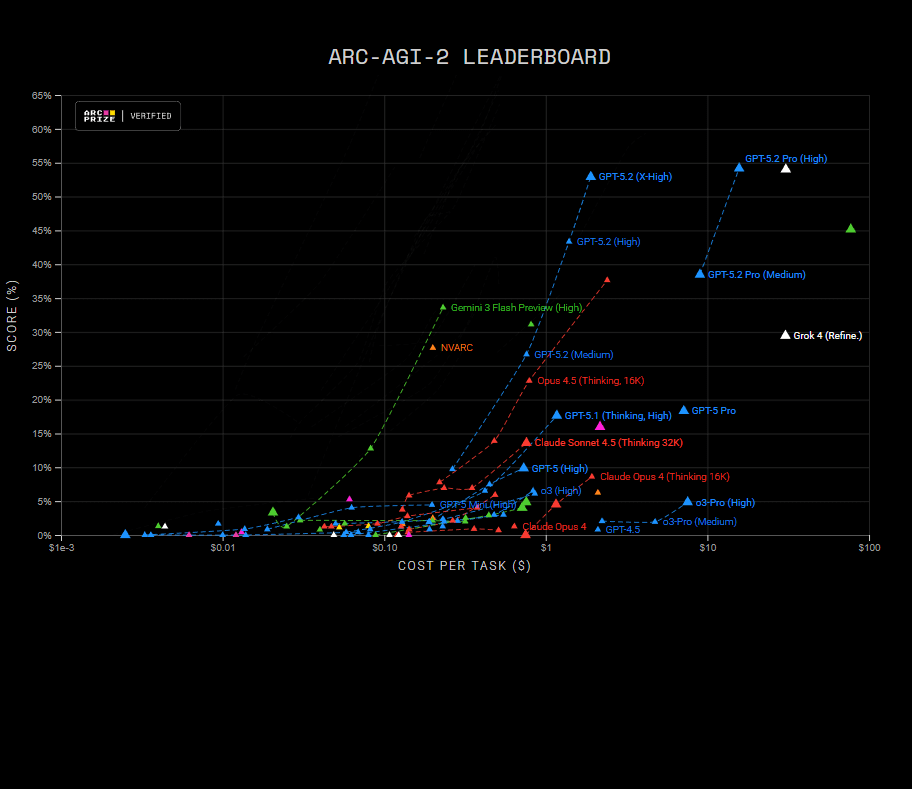

O ARC-AGI-2 é a evolução direta de um do benchmark ARC – Abstraction and Reasoning Corpus. Seu objetivo continua o mesmo – avaliar a inteligência dos modelos de IA – mas com regras mais duras: avaliar se um modelo consegue aprender e generalizar padrões novos com pouquíssimos exemplos, algo que humanos fazem naturalmente, mas que modelos atuais ainda têm enorme dificuldade em replicar.

Enquanto muitos benchmarks modernos medem memória, escala ou exposição prévia a dados, o ARC-AGI-2 tenta responder uma pergunta mais incômoda: a IA está realmente raciocinando ou apenas reconhecendo padrões já vistos?

O problema que o ARC original expôs

Em 2019, François Chollet, criador do Keras, uma biblioteca open source de deep learning adotada por mais de 2,5 milhões de desenvolvedores, publicou o artigo “On the Measure of Intelligence”, no qual introduziu o Abstract and Reasoning Corpus (ARC-AGI), um benchmark voltado à Inteligência Artificial Geral, concebido para medir a inteligência fluida.

O ARC original partia de uma crítica clara: modelos de IA têm desempenho impressionante em tarefas estatísticas, mas falham quando precisam abstrair regras novas. No ARC, cada tarefa apresenta 2 a 5 exemplos de entrada → saída, e o modelo deve inferir a regra implícita. Depois, deve aplicar essa regra a um novo input inédito.

Humanos resolvem muitas dessas tarefas em segundos. Modelos gigantes, mesmo treinados em volumes colossais de dados, historicamente falham ou exigem fine-tuning pesado — o que viola a ideia de aprendizado geral.

Por que o ARC-AGI-2 foi criado?

O sucesso parcial de alguns modelos no ARC original trouxe um problema: overfitting ao benchmark. Com o tempo, arquiteturas, prompting e técnicas auxiliares começaram a “decorar” o estilo das tarefas. O ARC-AGI-2 surgiu justamente para evitar este problema.

Embora o espírito do benchmark seja o mesmo, o ARC-AGI-2 traz mudanças importantes: muitas tarefas exigem inferir intenções implícitas. O benchmark premia eficiência cognitiva, não poder de cálculo.

O ARC-AGI-2 não quer saber se o modelo resolve muitas tarefas fáceis. Ele quer saber se o modelo consegue resolver tarefas conceitualmente novas. Um único erro conceitual invalida a solução — exatamente como acontece no raciocínio humano.

Por que o ARC-AGI-2 importa tanto?

O ARC-AGI-2 questiona a narrativa de “AGI iminente”: ele expõe limites reais do aprendizado auto-supervisionado. Mesmo com avanços recentes em modelos fundacionais, os desempenhos continuam baixos. Modelos de IA superam humanos em tarefas complexas, mas ainda tropeçam em puzzles simples do ARC-AGI-2.

Quer saber mais sobre benchmarks? Acesse: Testes