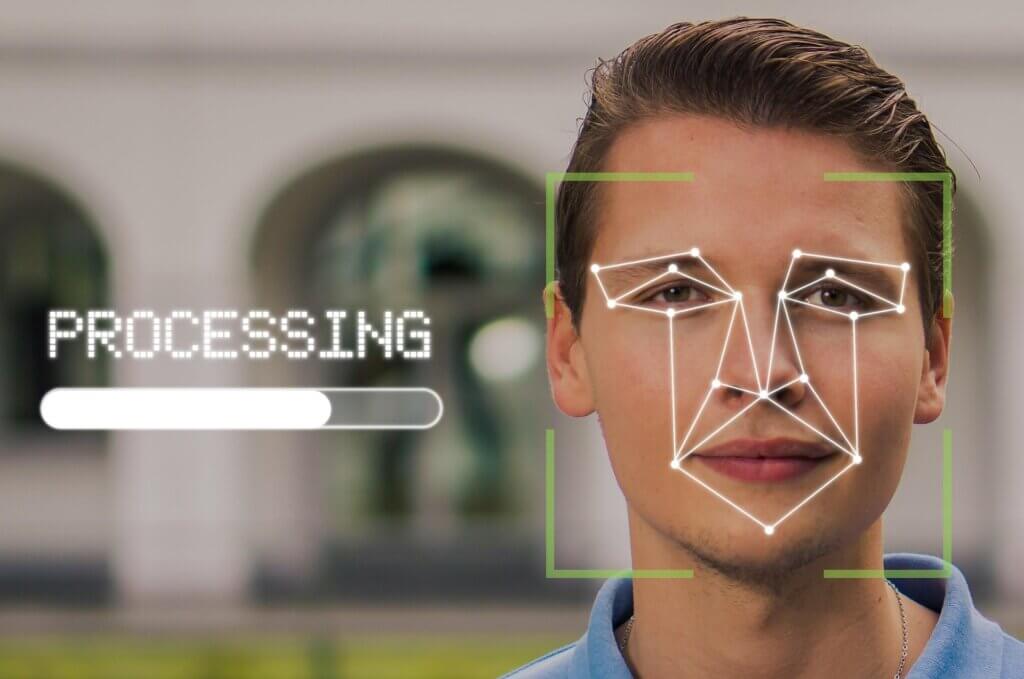

O avanço acelerado das tecnologias de IA generativa tornou cada vez mais simples criar conteúdos audiovisuais realistas a partir da imagem ou da voz de pessoas reais. Os chamados deepfakes — vídeos, áudios ou imagens sintéticas que simulam indivíduos reais — colocam em xeque conceitos tradicionais como direito de imagem, privacidade, liberdade de expressão e integridade do processo democrático.

Por que as deepfakes preocupam

O problema surge quando esse tipo de conteúdo é utilizado sem consentimento, para enganar o público, manipular opiniões ou causar danos reputacionais, econômicos ou psicológicos.

Um dos casos mais emblemáticos ocorreu em 2018, quando um vídeo amplamente divulgado mostrava o então ex-presidente dos Estados Unidos, Barack Obama, aparentemente fazendo declarações ofensivas. O vídeo era falso e foi produzido como um alerta sobre o potencial de desinformação da tecnologia, mas demonstrou com clareza o nível de realismo que os deepfakes já haviam alcançado.

Problemas recentes: Coreia do Sul e Turquia

Nos últimos anos, diferentes países passaram a enfrentar problemas concretos relacionados ao uso abusivo de deepfakes.

Na Coreia do Sul, autoridades identificaram um aumento expressivo de promoções enganosas nas redes sociais, nas quais deepfakes de celebridades eram utilizados para induzir consumidores a fraudes financeiras e esquemas de investimento inexistentes.

Já na Turquia, o uso de deepfakes em contexto eleitoral acendeu alertas sobre a manipulação do debate público, com conteúdos falsos atribuídos a candidatos e figuras políticas circulando durante períodos sensíveis do processo democrático.

Respostas regulatórias: o caso da Coreia do Sul

Diante desse cenário, a Coreia do Sul adotou uma abordagem regulatória mais proativa e intervencionista. Entre as principais medidas discutidas a serem adotadas estão a rotulagem obrigatória de conteúdos gerados ou significativamente alterados por IA; a análise de denúncias em até 24 horas, especialmente em casos envolvendo possíveis danos à reputação ou fraudes; e, sanções mais severas para quem cria ou dissemina deepfakes ilegais, incluindo multas elevadas e responsabilização criminal em casos graves.

A abordagem da União Europeia: o AI Act

Na União Europeia, o tema dos deepfakes é tratado principalmente no âmbito do AI Act, que adota uma lógica baseada em transparência e mitigação de riscos, em vez de uma proibição geral.

O regulamento prevê, entre outros pontos uma rotulagem explícita obrigatória (o formato exato ainda será definido futuramente) e uma rotulagem implícita obrigatória, com o uso de metadados, marcas d’água digitais ou sinais criptográficos. Esses mecanismos podem ser invisíveis ao usuário comum, mas detectáveis por ferramentas técnicas especializada.

Estados Unidos: Leis Estaduais

Nos Estados Unidos, não existe uma legislação federal abrangente sobre deepfakes, mas sim um conjunto de iniciativas setoriais. Em nível federal, destaca-se o Take It Down Act (2025), que criminaliza a divulgação de imagens íntimas não consensuais, inclusive aquelas criadas por IA.

Além disso, diversos estados aprovaram leis específicas, com foco em dois grandes eixos: 1) Deepfakes eleitorais, geralmente proibidos ou restritos em períodos próximos às eleições; e, 2) Deepfakes pornográficos não consensuais, com sanções civis e criminais.

Singapura: Foco em deepfakes eleitorais

Em Singapura, a legislação proíbe explicitamente o uso de deepfakes eleitorais durante períodos de campanha, reforçando a proteção à integridade do processo democrático.

O caso brasileiro: o PL 4.400/2024

No Brasil, o debate ganhou força com o PL 4.400/2024, que propõe a criação do conceito de “réplica digital”. O projeto exige autorização prévia e expressa da pessoa retratada para o uso de sua imagem ou voz em conteúdos sintéticos.

Assim como no PL de IA (PL 2.338/2023), a abordagem inicial brasileira é significativamente mais rígida do que a adotada em outras jurisdições, já que exige autorização para qualquer manipulação de imagem – mais semelhante a uma proibição a priori. Embora fortaleça a proteção ao direito de imagem, ela levanta preocupações sobre: risco de censura excessiva; remoção preventiva de conteúdos legítimos; e, impactos negativos sobre liberdade de expressão, sátira, jornalismo e usos artísticos.

Nos debruçaremos mais sobre o caso brasileiro nos próximos artigos.

Conclusão

O debate regulatório sobre deepfakes parece caminhar, cada vez mais, para um conjunto de princípios comuns, adotados — com variações — por diferentes jurisdições.

A tendência predominante não é a proibição geral da tecnologia, mas sim a permissão como regra, acompanhada de obrigações claras de transparência e responsabilização. Nesse modelo, os deepfakes são admitidos em usos legítimos — artísticos, educacionais, jornalísticos, comerciais ou de entretenimento — desde que respeitados determinados requisitos.

Entre esses requisitos, destaca-se a rotulagem obrigatória: tanto a rotulagem explícita, visível ao usuário final, informando que o conteúdo foi gerado ou manipulado por IA, quanto a rotulagem implícita, por meio de metadados ou marcas d’água digitais, detectáveis por ferramentas técnicas, mas não necessariamente perceptíveis ao público comum.

Ao mesmo tempo, consolida-se um núcleo de usos proibidos e sujeitos a sanções mais severas, em razão do alto potencial de dano, como conteúdo sexual não consensual e deepfakes envolvendo atores políticos em período eleitoral.

Além desses casos, a maior parte das jurisdições tende a tratar os deepfakes ilícitos a partir de tipos jurídicos já conhecidos, como: crimes contra a honra (calúnia, difamação e injúria); estelionato e fraude; e uso comercial indevido da imagem ou da voz, especialmente sem consentimento ou fora dos limites contratuais.

Nesse contexto, o desafio regulatório não está em banir a tecnologia, mas em distinguir usos legítimos de usos abusivos, garantindo proteção efetiva a direitos fundamentais sem inviabilizar inovação, liberdade de expressão e atividades econômicas lícitas.