Prompt injection ocorre quando um terceiro insere instruções maliciosas em conteúdos que um agente de IA lê e interpreta. Se o sistema não conseguir distinguir claramente entre comandos fornecidos pelo usuário e instruções embutidas em um e-mail, página web ou documento, ele pode acabar executando ações indesejadas — como enviar mensagens, alterar informações ou realizar operações não autorizadas.

Estudo da OpenAI (Continuously hardening ChatGPT Atlas against prompt injection attacks) analisa esse risco em um modo agente, no qual a IA é capaz de navegar, clicar e interagir autonomamente com páginas da web, de forma semelhante a um usuário humano. Embora esse tipo de automação amplie significativamente a utilidade do sistema, ele também expande a superfície de ataque, já que qualquer conteúdo externo — e-mails, posts ou sites — pode conter prompts maliciosos ocultos.

Defesa contra Prompt Injection com Automated Red Teaming

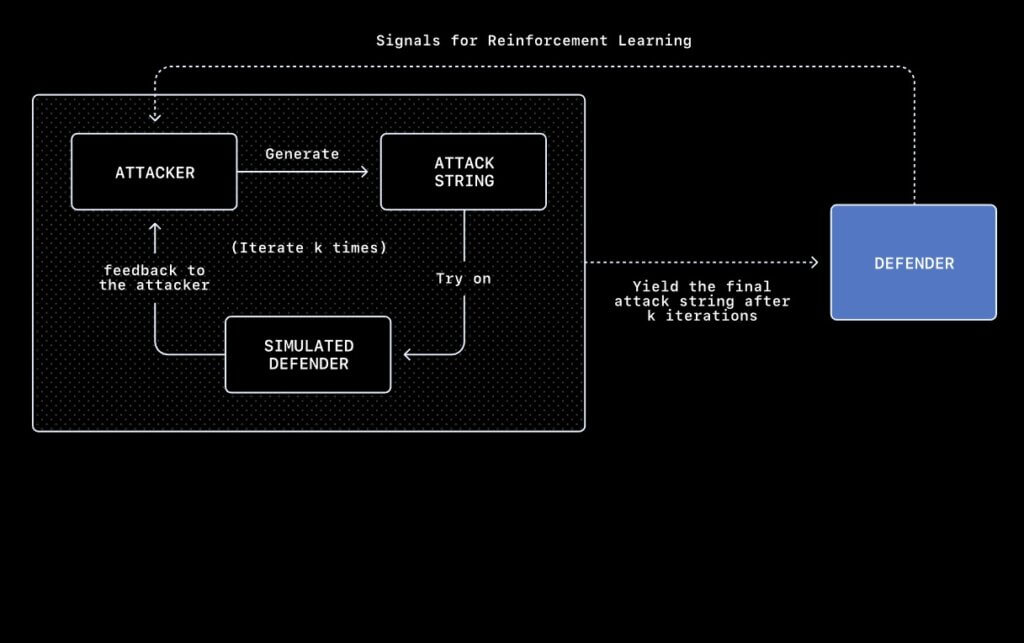

Para enfrentar esse problema, a OpenAI desenvolveu um sistema de red teaming automatizado baseado em reinforcement learning. Nesse modelo:

- Um agente atacante é treinado para descobrir novos tipos de ataques de prompt injection antes que eles apareçam em cenários reais;

- Esse agente testa repetidamente possíveis injeções, simulando como o sistema reagiria e identificando padrões de ataque ainda não reconhecidos;

- Os ataques descobertos alimentam um loop de resposta rápida, no qual o sistema é continuamente retreinado para ignorar instruções maliciosas e fortalecer suas defesas.

Um exemplo concreto apresentado no estudo mostra o agente lendo um e-mail com instruções ocultas que, sem proteção adequada, poderiam levá-lo a enviar uma carta de demissão em nome do usuário, sem que este percebesse. Após o reforço das defesas, o sistema passou a detectar e bloquear esse tipo de tentativa de prompt injection.

Estratégias de defesa e recomendações

A abordagem adotada pela OpenAI contra o prompt injection combina múltiplas camadas de proteção, incluindo:

- Treinamento adversarial contínuo contra novos vetores de ataque;

- Melhorias sistêmicas além do modelo, como monitoramento, separação de contextos e instruções explícitas de segurança;

- Boas práticas para usuários, como limitar acessos logados, exigir confirmações antes de ações sensíveis e fornecer instruções claras ao agente.

Apesar dos avanços, o artigo deixa claro que prompt injection é um desafio persistente no contexto de agentes de IA. Em vez de uma solução definitiva, o problema exige estratégias contínuas de mitigação, atualizações constantes e defesa em profundidade — de forma semelhante a outros riscos estruturais de segurança digital.

Se quiser saber mais sobre riscos de segurança: Segurança